Loading...

Hat die Skalierung von KI an eine Grenze erreicht?

18.04.2025

Zusammenfassung

Von LeNet bis GPT-4 hat KI eine zehnjährige Welle exponentiellen Wachstums erlebt. Doch angesichts steigender Kosten, begrenzter Daten und abnehmender Erträge stellt sich die Frage: Ist diese Welle nun gebrochen?

1. Einleitung

Als ich 2022 zum ersten Mal einen Prompt an die damals gehypte App namens ChatGPT schickte, hätte ich nie gedacht, wie radikal sich die KI-Welt verändern würde. Damals war ich fasziniert von der scheinbar magischen Fähigkeit des Modells, Text und Code zu erzeugen. Heute stelle ich mir ganz andere Fragen: Hat die Entwicklung von KI ihre Grenzen erreicht? War das exponentielle Wachstum der letzten Jahre nur eine vorübergehende Phase?

Vielleicht hast du auch schon Überschriften wie „Hat KI eine Wand erreicht?“ gelesen oder dich gefragt, warum OpenAI angeblich plant ein 2.000-Dollar-Abo anzubieten. Auf den ersten Blick wirkt das widersprüchlich, schließlich feiern die Medien KI weiterhin als die revolutionärste Technologie unserer Zeit, während Leute wie Sam Altman und Dario Amodei von einer nahen Zukunft mit AGI (Artificial General Intelligence) sprechen.

Nach unzähligen Stunden mit Fachartikeln, Vorträgen und Modell-Experimenten will ich in diesem Artikel die beeindruckende Geschichte moderner KI-Modelle erzählen. Es ist eine Reise voller überraschender Durchbrüche, gewagter Finanzwetten und einer zentralen Erkenntnis, die die KI-Entwicklung der letzten Dekade geprägt hat: Bigger really is better.

Komm mit auf diese Reise von den bescheidenen Anfängen neuronaler Netze bis zu den heutigen Giganten und lass uns herausfinden, ob das Zeitalter des bloßen Skalierens wirklich an sein Ende kommt oder ob wir gerade erst am Anfang eines noch spannenderen Kapitels stehen.

2. AlexNet – Der Ursprung der Scaling Idee

Die Ideen hinter den heutigen KI-Durchbrüchen sind im Kern bereits relativ alt. Sie existierten schon Jahrzehnte, bevor jemand ihr wahres Potenzial erkannt hat.

Eines der ersten erfolgreichen neuronalen Netze war LeNet, entwickelt 1989 von Yann LeCun bei den Bell Labs. Inspiriert vom menschlichen visuellen Kortex entwarf er ein Convolutional Neural Network, um handgeschriebene Ziffern zu klassifizieren. Das Modell hatte nur ein paar tausend Parameter, was aus heutiger Sicht lächerlich wenig sind. Das Hauptproblem damals war die Rechenleistung: sehr teuer, sehr langsam und stark begrenzt. Alles lief auf CPUs, die keine parallele Verarbeitung konnten und damit komplett ungeeignet waren, um solche Modelle sinnvoll skalieren zu können.

LeCun machte trotzdem weiter. 1998 kam dann letzenendlich LeNet-5 heraus, eine verbesserte Version mit mehr Schichten und insgesamt rund 60.000 Parametern, was für die damalige Zeit eine deutliche Ansage war. Aber auch dies war immernoch durch die geringe CPU-Power limitiert. Der Fortschritt blieb aus, weil die Hardware einfach nicht mitspielte.

Die frühen 2000er waren dann eine Art technischer Stillstand. In der Forschung war man überzeugt: Nur neue Algorithmen bringen Fortschritt. Einfaches Hochskalieren sei eine Sackgasse.

Dann kam 2012. Und alles änderte sich.

Alex Krizhevsky, Ilya Sutskever und Geoffrey Hinton gewannen die ImageNet Challenge mit einem Modell namens AlexNet und zwar mit riesigem Abstand. Das war kein Durchbruch durch die Entwicklung eines neuen Algorithmus. Sondern vielmehr, weil sie eine bestehende CNN Architektur einfach stark skalierten: 60 Millionen Parameter. Damals undenkbar.

Alex Krizhevsky, Ilya Sutskever und Geoffrey Hinton gewannen die ImageNet Challenge mit einem Modell namens AlexNet und zwar mit riesigem Abstand. Das war kein Durchbruch durch die Entwicklung eines neuen Algorithmus. Sondern vielmehr, weil sie eine bestehende CNN Architektur einfach stark skalierten: 60 Millionen Parameter. Damals undenkbar.

Sutskever erklärte später, was ihnen bereits zuvor klar wurde: Tiefe Netze mit vielen Layers lassen sich, entgegen der öffentlichen Meinung, sehr wohl trainieren und zwar mit dem bekannten Backpropagation-Algorithmus und den richtigen Tools. Der Schlüssel dabei war die Nutzung von Grafikkarten (GPUs), die bis dahin fast ausschließlich für Gamingzwecke verwendet wurden. Damit war auf einmal massive Parallelverarbeitung möglich und somit eine deutliche Skalierung der Modelle doch möglich.

Was mich besonders überrascht hat: Verantwortlich für den Durchbruch war vielmehr ein "Engineering-Durchburch" als ein "Research-Durchbruch"

AlexNet wurde damit der erste echte Beweis für eine neue Idee: Wer skaliert, gewinnt. Eine Erkenntnis, die den Kurs der KI bis heute bestimmt.

3. GPT - Skalierung trifft auf natürliche Sprache

Die Transformer-Architektur

Bis 2017 wurde die Verarbeitung natürlicher Sprache hauptsächlich mit sogenannten rekurrenten neuronalen Netzen (RNNs) durchgeführt, einer Architektur mit einem verborgenen Zustand, der Informationen sequenziell speichert.

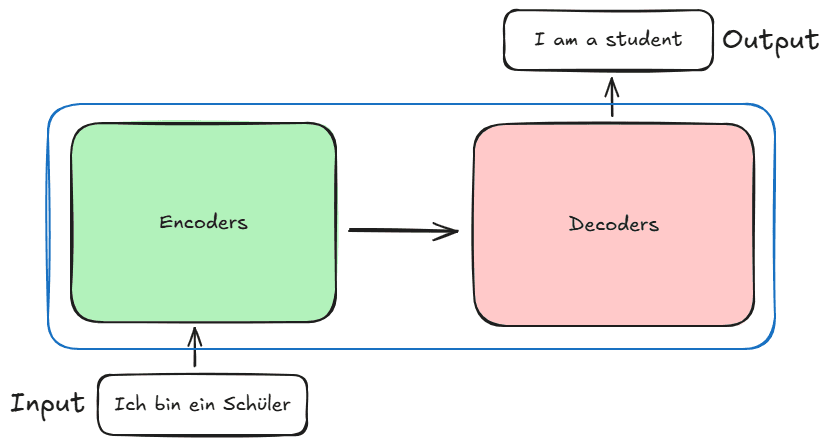

Im Jahr 2017 veröffentlichte dann ein Forscherteam von Google Brain und Google Research ein Paper namens „Attention is all you need", welche die Transformer-Architektur der Öffentlichkeit vorstellte. Dabei handelt es sich um eine fundamental neue Architektur, die ursprünglich für maschinelle Übersetzung entwickelt wurde. Sie besteht aus zwei Teilen: einem Encoder-Teil, der Text in einen hochdimensionalen Raum transformiert, und einem Decoder, der diese hochdimensionale Repräsentation nutzt, um das nächste Token vorherzusagen.

Die Stärke der Transformer-Architektur liegt in mehreren entscheidenden Vorteilen:

- Sie stützt sich stark auf den Self-Attention-Mechanismus, der es ihr ermöglicht, die Bedeutung verschiedener Wörter im Kontext zu gewichten

- Im Gegensatz zu RNNs ist sie nicht rekurrent, was sie weniger tief und dementsprechend einfacher zu optimieren macht

- Sie parallelisiert extrem gut und läuft viel schneller auf GPUs

- Sie erzielt bessere Ergebnisse mit weniger Rechenressourcen

Diese architektonische Innovation legte den Grundstein für alle modernen großen Sprachmodelle, die wir heutzutage unter dem Begriff "LLMs" kennen.

GPT-1

Ein Jahr nach der Transformer-Veröffentlichung, 2018, veröffentlichten Forscher bei OpenAI GPT-1 (Generative Pretrained Transformer), ein Modell, das nur auf dem Decoder-Teil der ursprünglichen Transformer-Architektur basierte. Die fundamentale Idee war, ausschließlich die Fähigkeit des Decoders der Transformer-Architektur zu nutzen, das nächste Token in einer Sequenz vorherzusagen, um völlig neuen Text basierend auf einer gegebenen Eingabe zu generieren. GPT-1 hatte dabei etwa 117 Millionen Parameter, was für seine Zeit beträchtlich war und wurde mit etwa 40 Milliarden Token an Textdaten trainiert. Das Team, geleitet von Ilya Sutskever (der Teil des früheren AlexNet-Teams war), baute stark auf dieser früheren Thesis auf, dass Skalierung zu besseren Ergebnissen führt, anstatt sich auf komplexe architektonische Innovationen zu konzentrieren. GPT-1 performte für seine Zeit und Größe beeindruckend und zeigte die ersten Anzeichen, dass der Skalierungsansatz, der die Computer Vision revolutioniert hatte, auch erfolgreich auf die Verarbeitung natürlicher Sprache angewendet werden konnte, was den Beginn der Pretraining-Ära in der Sprachverarbeitung (NLP) markierte.

GPT-2

Ein weiteres Jahr später, 2019, veröffentlichte das Team bei OpenAI den Nachfolger von GPT-1: GPT-2. Im Gegensatz zu seinem Vorgänger wurde diese Version nicht als einzelnes Modell veröffentlicht, sondern als eine Reihe von Modellen mit verschiedenen Größen, die von 124 Millionen bis 1,5 Milliarden Parameter reichten. Diese Modelle behielten dabei dieselbe Architektur wie GPT-1 bei, wurden jedoch massiv hochskaliert.

GPT-2 validierte weiterhin die Idee, dass Skalierung zu besseren Ergebnissen führt, durch drei Schlüsseldimensionen: mehr Parameter, mehr und bessere Datenqualität sowie mehr Rechenleistung. Die Ergebnisse waren beeindruckend: GPT-2 demonstrierte eine viel bessere Leistung bei der Textgenerierung, zeigte verbesserte Fähigkeiten bei der Durchführung von „Zero-Shot"-Aufgaben (Aufgaben, für die es nicht explizit trainiert wurde), und konnte ein deutlich größeres Kontextfenster handhaben, was es ihm ermöglichte, Kohärenz über längere Texte aufrechtzuerhalten. Aber bis auf einige KI-Forscher erlangte das Modell kaum große öffentliche Anerkennung.

GPT-3

2020 veröffentlichte OpenAI GPT-3, die dritte Version der GPT-Reihe und wieder handelte es sich um eine massiv hochskalierte Version ihrer gleichbleibenden GPT-Architektur. Basierend auf ihrem Forschungspaper „Scaling Laws for Neural Language Models", das wir im nächsten Kapitel behandeln, nahm das Team ein massives finanzielles Risiko von etwa 4,6 Millionen USD auf sich, um das Modell auf 175 Milliarden Parameter zu skalieren, was mehr als 100-mal größer ist als die größte Version von GPT-2. Dazu nutzten auch einen enorm erweiterten Datensatz von Hunderten von Milliarden Token.

Die Ergebnisse waren bemerkenswert. Über die bloße Verbesserung bestehender Metriken hinaus entwickelte GPT-3 überraschend neue Fähigkeiten, die in kleineren Modellen nicht beobachtet worden waren. Am bedeutsamsten war, dass es beeindruckende Few-Shot-Lernfähigkeiten demonstrierte, die Fähigkeit, völlig neue Aufgaben durchzuführen, nachdem es nur wenige Beispiele gesehen hatte, ohne jegliche Parameteraktualisierungen. Das ist erstaunlich, wenn man darüber nachdenkt: Einfach das Modell hochzuskalieren führte zu einem ganz neuen Set an Fähigkeiten!

GPT-4

Mit der erfolgreichen Veröffentlichung von ChatGPT im Jahr 2022 hatte OpenAI bereits demonstriert, dass ihre GPT-3-Modelle eine großartige Grundlage für ein erfolgreiches Produkt sind. Im Frühjahr 2023, wenige Monate nach dem ChatGPT-Moment, veröffentlichte OpenAI GPT-4, ihr bisher fortschrittlichstes Modell, das die Fähigkeiten von ChatGPT weiter verbesserte.

Auf den ersten Blick waren die Fortschritte nicht direkt bemerkbar, nach längeren nutzen zeigte sich jedoch, dass GPT-4 eine viel höhere Zuverlässigkeit bei komplexen Aufgaben erreiche konnte, merklich weniger Halluzinationen produzierte und zum ersten Mal multimodale Features einführte, die es Nutzern ermöglichten, nicht nur Text, sondern auch Bilder als Input bereitzustellen. Dies stellte einen bedeutenden Sprung nach vorne dar, sowohl in Bezug auf Fähigkeiten als auch Nutzbarkeit.

Diese Veröffentlichung markierte jedoch eine signifikante Verschiebung in OpenAIs ursprünglicher Mission: Transparenz. Im Gegensatz zu früheren Iterationen, bei denen das Unternehmen detaillierte Forschungspapiere und die Modellgewichte veröffentlichte, kam GPT-4 mit nahezu keinen Informationen über das Modell und den Trainingsprozess. Dieser Mangel an Transparenz kommt wahrscheinlich von OpenAIs Übergang von einer forschungsfokussierten Organisation zu einem kommerziellen Unternehmen. Mit der enormen Nachfrage nach ihren Produkten und dem zunehmenden Wettbewerb im KI-Bereich scheint das Unternehmen eine strategische Entscheidung getroffen zu haben, ihr geistiges Eigentum zu schützen und zu versuchen, ihren Wettbewerbsvorteil zu bewahren, indem sie technische Details geheim halten.

4. Die Scaling-Laws

Wie ich im Abschnitt zu GPT-3 bereits erwähnte, war einer der Hauptgründe, warum die Forscher von OpenAI ein so massives finanzielles Risiko zur Skalierung eingingen, die Theorie der "Scaling Laws". In diesem Abschnitt werden wir uns genau ansehen, was diese Gesetze aussagen.

Seit den frühen Tagen von GPT war den Forschern klar, dass Modellgröße, Datensatzgröße und die Menge an Rechenleistung, die zum Trainieren des Modells verwendet wird, die Hauptfaktoren hinter dem Erfolg sind. Durch die Analyse dieser drei Faktoren über alle Modelle hinweg, die sie trainiert hatten, entdeckten die Forscher faszinierende Muster. Diese Beobachtungen führten zur Veröffentlichung des Papers „Scaling Laws for Neural Language Models" von OpenAI im Jahr 2020, in dem sie ihre Erkenntnisse als empirische Gesetze teilten.

Die Frage, die diese Untersuchungen antrieb, war, ob sie Muster finden könnten, die die Leistung viel größerer Modelle vorhersagen würden, bevor sie diese tatsächlich trainierten. Basierend auf diesen Gesetzen trafen sie die Entscheidung, in das Training des massiven GPT-3-Modells zu investieren.

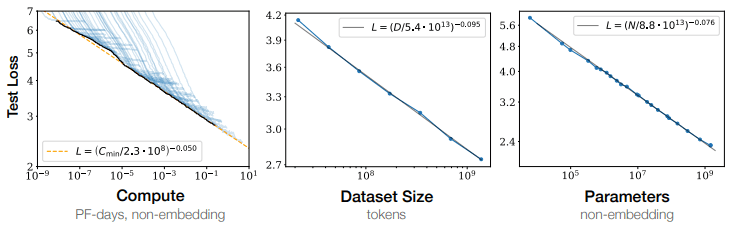

Das Scaling-Laws-Paper enthüllte, dass die Modellleistung hauptsächlich von drei verschiedenen Variablen abhängt:

- Die Anzahl der Parameter (Größe des Modells)

- Die Menge an Trainingsdaten (gemessen in Token)

- Die Menge an Rechenleistung, die zum Trainieren des Modells verwendet wird

Jede dieser Variablen korreliert auf vorhersagbare Weise mit der Modellleistung, vorausgesetzt, sie wird nicht durch die anderen Variablen ausgebremst. Die Leistung wird durch den Test-Loss gemessen (wie genau das Modell das nächste Token in einer Sequenz vorhersagt – niedriger ist besser).

Was diese Gesetze besonders mächtig macht, ist, dass sie überraschend sauberen Potenzgesetz-Beziehungen folgen, wenn sie auf logarithmischen Skalen dargestellt werden, wie in den obigen Graphen gezeigt, bilden sie nahezu gerade Linien. Das bedeutet, dass die Leistungsverbesserung einem vorhersagbaren mathematischen Muster folgt, wenn man alle dieser Faktoren in gleichem Verhältnis erhöht.

Der linke Graph zeigt, wie sich die Leistung mit mehr Rechenleistung verbessert. Der mittlere Graph demonstriert die Beziehung zwischen Datensatzgröße und Leistung. Der rechte Graph illustriert, wie die Erhöhung der Parameteranzahl die Leistung beeinflusst.

Diese empirischen Gesetze wiesen klar in eine Richtung: Skaliere die Modellgröße, die Trainingsdaten und die Rechenressourcen im richtigen Verhältnis hoch, und du wirst vorhersagbar bessere Modelle erhalten. Dies gab OpenAI das Vertrauen, die enorme Investition in GPT-3 zu tätigen, da sie mit bemerkenswerter Sicherheit wussten, welche Leistung sie erwarten konnten. Im Rückblick ist es immer noch faszinierend, wie genau vorhersagbar dieser Fortschritt war, jedoch zu damaliger Zeit waren die Skalierungsgesetze eine reine Beobachtung und niemand wusste mit Sicherheit, dass das auch für so viel größere Modelle wie GPT-3 immer noch korrekt passt.

5. Ist die Skalierung an eine Wand gestoßen?

Trotz des unwirklichen Erfolgs des einfachen Skalierungsansatzes gibt es wachsende Beweise, dass reine Skalierung irgendwann seine Grenzen erreichen wird. Mehrere Limitierungen wurden mit der Zeit zunehmend klarer, als die großen Tech-Firmen die Modellskalierung nochmal auf ein neues Level heben wollten.

Die offensichtlichste Limitation dabei ist, die bereits bei GPT-3 ein großes Risiko war, das kostenintensive Training. Die Trainingskosten sind innerhalb weniger Jahre auf beispiellose Höhen gestiegen. GPT-4 kostete beispielsweise Berichten zufolge über 100 Millionen Dollar zu trainieren. Diese Kostenexplosion wird von einigen Schlüsselfaktoren angetrieben. Zuallererst stieg die Nachfrage nach High-End-GPUs in die Höhe und mit ihr der Preis, was NVIDIA, die eine Art Monopol auf KI-Chips haben, für kurze Zeit zum wertvollsten Unternehmen der Welt machte. Als neue Konkurrenten das Potenzial von KI zu sehen begannen, fingen mehr Unternehmen an, solche Modelle zu trainieren, und ein Wettrüsten begann, das in einer Welt endete, in der das Risiko real ist, dass während die Unternehmen ihr neues Modell trainieren, ein anderes Modell ein signifikant besseres Modell veröffentlichen kann, was die anderen obsolet macht.

Während Rechenressourcen technisch nicht durch eine harte Wand begrenzt sind, wird die Ökonomie mit zunehmender Skalierung immer ungünstiger. Mit der weit verbreiteten Adoption von KI-Diensten wird nun ein signifikanter Teil der Rechenressourcen dafür verwendet, bestehende Modelle für Inferenz zu betreiben, statt neue zu trainieren. Diese Verschiebung beschränkt die verfügbaren Ressourcen für das Hochskalieren von Modellen weiter und vermindert den Return on Investment erheblich.

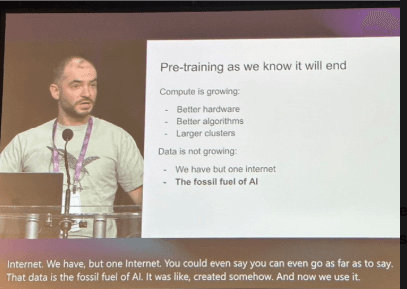

Die vielleicht fundamentalste Grenze ist die begrenzte Verfügbarkeit von Trainingsdaten. Da Modelle wie GPT-4 nahezu den kompletten im Internet verfügbaren hochwertigen Text verarbeitet haben, nähern wir uns einer Datenwand. Der Vorrat an von Menschen geschriebenem Text ist begrenzt, also könnte man darüber nachdenken, einfach synthetische Daten für das Training zu verwenden, aber der Punkt ist, die Verwendung synthetischer Daten riskiert, bestehende Verzerrungen und Halluzinationen zu nutzen, was das gesamte Modell vergiften könnte. Auch der Pionier der Skalierung Ilya Sutskever erklärete bei einer Rede auf der NeurIPS 2024, dass er denkt, dass Daten der limitierende Faktor der Pretraining-Ära sind und diese bald enden wird

Darüber hinaus zeigen die Skalierungsgesetze selbst einige kritische Anzeichen: Während die Leistung mit der Skalierung weiter zunimmt, nimmt die Rate der Verbesserung ab. Die logarithmische Natur dieser Verbesserungen bedeutet, dass eine Verdopplung der Parameter oder Trainingsdaten immer kleinere Gewinne bringt, das ist eine mathematische Realität, die nicht überwunden werden kann.

Eine weitere weiche, aber entscheidende Grenze ist, dass der Fokus auf Test-Loss-Optimierung zunehmend von der Nutzbarkeit in der realen Welt abgekoppelt ist. Die frühere Messung durch den Test-Loss und mehrere Benchmarks stimmt nicht mit den in der Praxis verwendeten Anwendungen überein, was zu einer fundamentalen Frage führt: Warum stecken wir so viele Ressourcen in das Erreichen der besten Punktzahl bei einem Benchmark, auch wenn es in realen Aufgaben nicht besser ist?

Das Skalierungsparadigma ist nicht an eine harte technische Wand gestoßen, sondern eher an eine ökonomische und praktische. Während KI von der Forschung zum Produkt übergeht, weicht der reine Skalierungsansatz einer nuancierteren Strategie, die Größe mit Effizienz, Qualität und praktischem Nutzen ausbalanciert..

6. Skalierung wird sich verändern

Also, ist die Skalierung zu einem Ende gekommen? In in gewisser Hinsicht. Die KI-Forschungslandschaft entwickelt sich kontinuierlich weiter und findet neue Wege vorwärts, selbst wenn traditionelle Skalierungsansätze auf Limitierungen stoßen. Was wir erleben, ist nicht das Ende der Skalierung, sondern ihre Transformation.

Es ist wichtig zu erinnern, dass wir hauptsächlich die Pretraining-Phase der Modellentwicklung diskutiert haben. Moderne KI-Systeme durchlaufen mehrere Trainingsstufen: Pre-Training, überwachtes Fine-Tuning und RLHF (Reinforcement Learning from Human Feedback). Dabei präsentiert jede Stufe ihre einzigartigen Möglichkeiten für Innovation und Optimierung.

Meiner Meinung nach ist einer der vielversprechendsten Ansätze das multimodale Lernen, was bedeutet, Bilder, Audio und Video in den Datensatz einzubeziehen. Dieser Ansatz könnte die bestehenden Grenzen verschieben und zu einem allgemeineren Modell führen, das die reale Welt auf eine tiefere Weise verstehen könnte. Die Herausforderung ist jedoch rechnerisch. Die Verarbeitung von Videodaten erfordert insbesondere deutlich mehr Ressourcen als Text allein, aber sie hat das Potenzial, die KI-Welt erneut umzugestalten.

Eine weitere innovative Richtung ist die Verlagerung der Skalierungsbemühungen vom Training zur Inferenz. Anstatt nur größere Modelle zu bauen, entwickeln Forscher Techniken, die es Modellen erlauben, mehr Zeit und Rechenleistung aufzuwenden, um über ein Problem zu „denken". Dieser Ansatz führt zu unglaublichen neuen Fähigkeiten der Modelle, wie das Durchführen beeindruckender Schlussfolgerungsschritte und das Verifizieren ihrer Ausgaben. OpenAIs o1/o3/o4-Modelle zeigen das Potenzial dieses Ansatzes und demonstrieren bemerkenswerte neue Fähigkeiten durch erweiterte Inferenzzeit-Berechnung statt nur roher Parameteranzahlen.

Diese Ansätze ermöglichen effektive Skalierung ohne den linearen Anstieg der Rechenanforderungen.

Das Skalierungsparadigma endet nicht, vielmehr entwickelt es sich weiter. Die fundamentale Erkenntnis, dass größere Modelle mit mehr Daten und Berechnung zu besserer Leistung führen, bleibt gültig, aber die Implementierung wird anspruchsvoller und nuancierter.

Während Modelle menschliches Leistungsniveau in verschiedenen Domänen erreichen, verschiebt sich der Fokus von roher Fähigkeit zu Zuverlässigkeit, Effizienz und spezialisierter Expertise. Die Zukunft der KI-Skalierung mag nicht einfach in Parameteranzahlen gemessen werden, sondern in der intelligenten Orchestrierung von Rechenressourcen über Training, Fine-Tuning und Inferenz hinweg.

Die Skalierungsrevolution ist jedoch nicht an eine Wand gestoßen, sie nimmt nur einen interessanteren und komplexeren Weg nach vorn. Während neue Innovationen und Techniken auftauchen, werden viele dieser Ideen durch ihre Hochskalierung verbessert werden.

Fazit

Meiner Meinung nach repräsentiert die Geschichte der Skalierung in der künstlichen Intelligenz eines der bemerkenswertesten Kapitel in der Geschichte der Technologie. Was 2012 mit der Fusion von GPUs und tiefen neuronalen Netzen begann, hat sich durch die Transformer-Revolution entwickelt und in eine neue Ära von Modellen mit atemberaubenden Fähigkeiten geführt. Während dieser ganzen Reise ist ein fundamentales Prinzip konsistent geblieben: Die Idee, Skalierung, an die ursprünglich kaum einer geglaubt hat, funktioniert!

Da KI jedoch von einer Art Forschungsprojekt für spezialisierte Anwendungen zu einer allgemeinen Verbrauchertechnologie übergeht, hat sich die Ökonomie der Skalierung fundamental verändert. Unternehmen müssen ihre Entwicklung zwischen Fähigkeit und finanzieller Machbarkeit ausbalancieren. Diese Verschiebung markiert nicht das Ende des Skalierungsparadigmas, sondern vielmehr eine Transformation in einen nuancierteren Ansatz.

Die Skalierungsära schuf eine Industrie, in der die Entwicklung von Spitzenmodellen enorme Kapitalinvestitionen erfordert, oft Hunderte von Millionen Dollar. Doch die Einnahmen, die diese Unternehmen aufrechterhalten, kommen hauptsächlich von der Inferenz durch das Bereitstellen dieser Modelle für Nutzer. Diese ökonomische Realität hat natürlich die Prioritäten in Richtung Effizienz und Optimierung verschoben, anstatt einfach die größtmöglichen Basismodelle zu erstellen.

Das bedeutet nicht, dass die Skalierungsära beendet ist. Vielmehr verschiebt sie sich zu einer maßvolleren und multidimensionaleren Weise als das exponentielle Wachstum, das wir zwischen GPT-1 und GPT-4 sahen. Skalierung bedeutet jetzt nicht nur, mehr Parameter und Daten hinzuzufügen, sondern sich auf architektonische Effizienz, Inferenzoptimierung, multimodale Fähigkeiten und spezialisierte Expertise zu fokussieren.

Wenn wir in die Zukunft blicken, werden die Unternehmen und Forscher erfolgreich sein, die verstehen, dass echte Skalierung nicht nur darum geht, Modelle größer zu machen, es geht darum, sie besser, effizienter und anpassungsfähiger an reale Bedürfnisse zu machen. Anthropic ist ein gutes Beispiel für diesen Trend, sie erkannten, dass eine signifikante Nutzung ihrer Claude-Modelle von Software-Ingenieuren erfolgt, also entschieden sie, ihr Sonnet-Modell speziell für Anwendungsfälle in diesem Bereich zu optimieren, was bemerkenswert gut funktionierte.

Wenn du tiefer in die Frage eintauchen möchtest, warum Skalierung überhaupt funktioniert, kann ich das neue Buch des Podcasters Dwarkesh Patel empfehlen: The Scaling Era: An Oral History of AI, 2019–2025

Aber behalte im Hinterkopf: Selbst die größten Köpfe unserer Zeit können die Zukunft nicht zu 100% vorhersagen.

Wenn du es bis hierher geschafft hast, danke für deine wertvolle Aufmerksamkeit.

Mario :D

-----

Sources

- Ilya Sutskever bei Lex Fridman (https://youtu.be/13CZPWmke6A?si=XYYYC0Y_1r0D-T-9)

- Dario Amodei bei Lex Fridman (https://www.youtube.com/watch?v=ugvHCXCOmm4&t=9791s)

- “Attention is all you need” paper: https://arxiv.org/abs/1706.03762

- GPT-1 post: https://openai.com/index/language-unsupervised/

- GPT-2 post: https://openai.com/index/gpt-2-1-5b-release/

- GPT-3 paper: https://arxiv.org/abs/2005.14165

- GPT-4 post: https://openai.com/index/gpt-4/

- Scaling Laws paper: https://arxiv.org/abs/2001.08361

- Ilya Sutskever Talk bei NeurIPS 2024: https://www.youtube.com/watch?v=1yvBqasHLZs&t=465s

- Dwakresh Patel The Scaling Era: An Oral History of AI, 2019–2025: https://amzn.eu/d/aY0LlKl